Ha piacvezető vagy, átérzem a fájdalmadat. Évek, évtizedek óta a márka láthatósága nagyrészt SEO fegyverkezési verseny volt a versenytársakkal szemben. Aztán jön a ChatGPT, a Perplexity és a Claude, nem is beszélve a Google új, AI-alapú keresési funkcióiról: az AI módról és az AI áttekintésekről. Hirtelen a márkája láthatóságát is figyelembe kell vennie az AI által generált válaszokban.

Sajnos azok a technikai parancsikonok, amelyek segítettek márkájának gyorsan alkalmazkodni és versenyképesek maradni az évek során, valószínűleg különféle örökölt problémákat hagytak maguk után. Ez a felhalmozott technikai SEO adósság potenciálisan tönkreteheti az AI láthatóságát.

Természetesen minden örökölt problémára vagy műszaki problémára lesz megoldás. De a legnagyobb kihívás a technikai SEO-tartozás kezelésében nem az összetettség vagy a hozzá nem értés; ez feltételezés.

A feltételezések a fehér hangyák a keresési stratégiában, kiüresítve a csapat taktikáját és a legjobb erőfeszítéseket. A felszínen még mindig szerkezetileg rendben lévőnek tűnhet minden, mert minden kár a ház falain belül, vagy a keresőoptimalizálási célok és a munkafolyamatok között történik. De aztán eljön az a szörnyű nap, amikor valaki akaratlanul is egy kis plusz nyomást fejt ki rossz helyen, és az egész sokaság beborul.

Az AI-keresés új követelményei jelenleg ezt a nyomást gyakorolják. Mennyire szilárd a technikai SEO?

Erős keresési rangsor ≠ AI láthatóság

Az egyik legveszélyesebb feltételezés az, ha azt gondolja, hogy mivel webhelye elég jó helyen szerepel a Google-ban, a technikai alapoknak szilárdnak kell lenniük. Tehát, ha a keresőmotoroknak nem okoz problémát a webhely feltérképezése és a tartalom indexelése, ugyanez igaz az AI-ra is, nem?

Rossz.

Oké, valójában van benne néhány feltételezés. De gyakran ez a helyzet: az egyik feltételezés félrevezető kontextust biztosít, amely másokhoz vezet, és a fehér hangyák elkezdik rágni a falakat.

Először foglalkozzunk ezzel a második feltételezéssel: Ha webhelye jó helyen szerepel a Google-ban, hasonló láthatóságot kell élveznie az AI-ban.

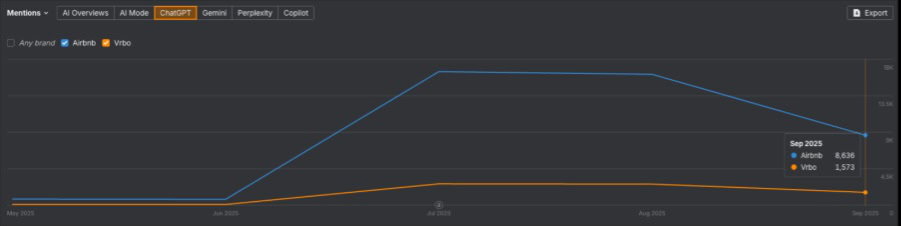

A közelmúltban összehasonlítottuk az Ahrefs adatait két nagy szálláshely-webhelynél: az Airbnb-nél és a Vrbo-nál.

Ha a márka nélküli keresést nézzük, július óta mindkét webhely csökkenő tendenciát mutat. A legfrissebb adatunk (2025. október 13-15.) szerint az Airbnb ~916 304 keresésnél, a Vrbo pedig ~615 497 keresésnél jelent meg. Ez nagyjából 3:2 arány.

De ha megnézzük a becsült ChatGPT említéseket (2025. szeptember), az Airbnb-nek ~8636, míg a Vrbo-nak csak ~1573-a van. Ez az arány ~11:2.

Ezen a ponton hozzá kell tennem egy figyelmeztetést, hogy minden mesterséges intelligenciával kapcsolatos adatkészlet korai és modellezett, ezért inkább tájékoztató jellegűnek, mint abszolútnak kell tekinteni. Az adatok azonban azt sugallják, hogy a Vrbo sokkal kevésbé jelenik meg a mesterséges intelligencia válaszaiban (és különösen a ChatGPT-ben), mint azt várná, ha bármilyen összefüggés lenne a keresési rangsorolással.

Mivel a Vrbo jelen van a Google organikus keresési eredményei között, szerény jelenléte van a Google AI áttekintéseiben és az AI módban. Ennek az az oka, hogy a Google mesterséges intelligencia funkciói továbbra is nagyrészt ugyanarra a keresési infrastruktúrára támaszkodnak.

És ez itt a fő probléma: nem csak a keresőmotorok küldenek feltérképező robotokat a webhelyére. És nem feltételezheti, hogy az AI-robotok ugyanúgy működnek.

Az AI-keresés felnagyítja technikai SEO-tartozásait

Szóval, mi a helyzet ezzel az első feltételezéssel: Ha webhelye jó helyen szerepel a Google-on, akkor a technikai adósságnak elhanyagolhatónak kell lennie.

A Google keresési infrastruktúrája rendkívül kifinomult, a jelek sokkal szélesebb körét fogadja, mint a mesterséges intelligenciarobotok. Mindezen jelzések halmozott hatása elfedheti vagy kompenzálhatja a kis mennyiségű technikai tartozást.

Például egy jól optimalizált másolattal, erős sémajelöléssel és megfelelő jogosultsággal rendelkező oldal még akkor is magasabb rangot kaphat, mint egy versenytársa, még akkor is, ha az oldal valamivel lassabban töltődik be.

A legtöbb AI feltérképező robot nem így működik. Eltávolítják a kódot, a formázást és a sémajelölést, hogy csak a nyers szöveget dolgozzák fel. A dolgok kiegyensúlyozására szolgáló egyéb jelek csökkenése miatt minden, ami akadályozza a feltérképező robotot abban, hogy hozzáférjen a tartalomhoz, nagyobb hatással lesz a mesterséges intelligencia láthatóságára. Technikai adósságának nincs hova bújnia.

A Need For Speed

Nézzük csak a technikai SEO adósság egyik leggyakoribb formáját: az oldalsebességet.

Az optimálisnál alacsonyabb sebességnek ritkán van egyetlen oka. Ez általában több tényező kombinációján múlik – duzzadt kód, nem hatékony CSS, nagy JavaScript-kötegek, túlméretezett képek és médiafájlok, rossz infrastruktúra stb.

Igen, itt-ott a másodperc töredékeiről beszélhetünk, de a felhalmozódó problémák negatív hatással lehetnek a felhasználói élményre. Ez az oka annak, hogy a gyorsabb webhelyek általában magasabb rangot kapnak; A Google az oldal sebességét közvetlen rangsorolási tényezőként kezeli a keresésben.

Úgy tűnik, hogy az oldalsebesség is jelentős tényező abban, hogy milyen gyakran jelenik meg a tartalom a Google új AI-módjában.

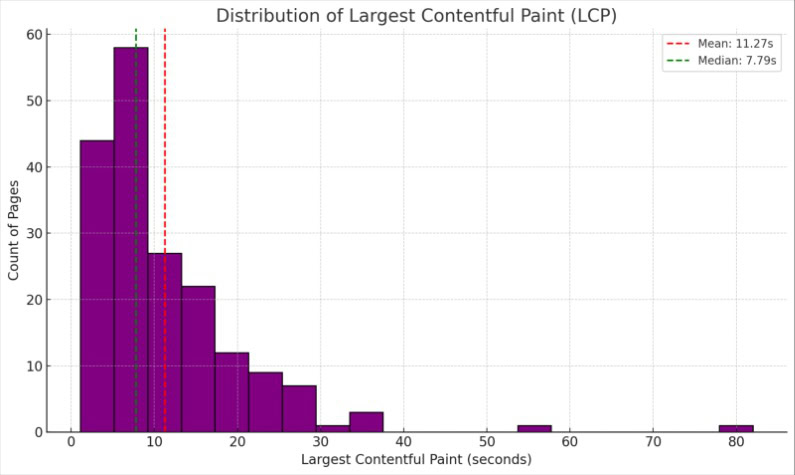

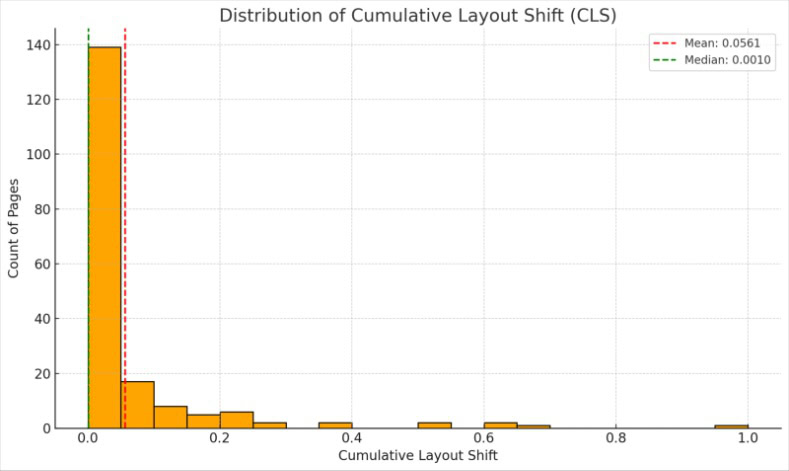

Dan Taylor a közelmúltban 2138, az AI mód válaszaiban hivatkozásként megjelenő webhely adatait tördelte, hogy megnézze, van-e összefüggés a hivatkozások gyakorisága és az LCP- és CLA-pontszámuk között. Azt tapasztalta, hogy a lassabb betöltési idővel rendelkező webhelyek AI módban való hivatkozása egyértelműen visszaesett.

Megvizsgáltunk egy másik népszerű módszert is, amelyet a webhelyek tulajdonosai használnak az oldalsebesség felmérésére: a Google PageSpeed Insights (PSI) eszközét. Ez egy csomó mérőszámot összesít, beleértve a fenti kettőt és sok mást is, hogy 100-ból összpontszámot kapjon. Azonban nem találtunk összefüggést a PSI-pontszámok és az idézetek között AI módban.

Tehát bár a PageSpeed Insights hasznos diagnosztikai információkat nyújthat, azonosítva a betöltési időket befolyásoló különböző problémákat, a webhely alapvető webes vitaljai megbízhatóbb mutatói annak, hogy a webhely látogatói és feltérképező robotjai milyen gyorsan és hatékonyan férhetnek hozzá a tartalomhoz.

Tudom, mire gondol: ezek az adatok a Google mesterséges intelligenciájára korlátozódnak. Nem árul el semmit arról, hogy ugyanez igaz-e a láthatóságra más AI-platformokon.

Jelenleg nem állnak rendelkezésre nyilvánosan elérhető adatok ahhoz, hogy ugyanezt az elméletet tesztelhessük más ügynöki segédeszközökkel, például a ChatGPT-vel, de a nyomok mind rendelkezésre állnak.

A feltérképezés költséggel jár

Még júliusban, az OpenAI munkatársa, Sam Altman azt mondta az Axiosnak, hogy a ChatGPT naponta 2,5 milliárd felhasználói értesítést kap. Összehasonlításképpen, a SparkToro becslései szerint a Google napi 16,4 milliárd keresési lekérdezést szolgál ki.

Az egyes mesterségesintelligencia-platformokat működtető nagy nyelvi modell (LLM) kétféleképpen reagál a felszólításra:

- Az edzési adatok nagy készletéből merítve.

- Botok vagy bejárók kiküldése, hogy valós időben ellenőrizzék és kiegészítsék az információkat további forrásokból származó adatokkal.

A ChatGPT valós idejű bejáróját ChatGPT-Usernek hívják. A cikk írásakor az elmúlt hét napban a ChatGPT-User körülbelül 6000 alkalommal látogatta meg a SALT.agency webhelyet. Ugyanebben az időszakban a Google keresőrobotja, a Googlebot ~2500 alkalommal kereste fel weboldalunkat.

Naponta több milliárd felszólítás kezelése hatalmas mennyiségű feldolgozási energiát fogyaszt. Az OpenAI becslései szerint jelenlegi bővítési tervei 10 gigawatt teljesítményt igényelnek, ami nagyjából 10 atomreaktor teljesítménye.

A SALT webhely 6000 feltérképezése közül mindegyik ezekre a számítási erőforrásokra támaszkodott. A lassú vagy nem hatékony webhely azonban arra kényszeríti a robotot, hogy még többet égessen el ezekből az erőforrásokból.

Ahogy a felszólítások mennyisége folyamatosan növekszik, a feltérképezés összesített költsége csak nő. Egy bizonyos ponton az AI-platformok nem tehetnek mást, mint hogy javítsák feltérképező robotjaik költséghatékonyságát (ha még nem tették meg), elkerülve azokat a webhelyeket, amelyek feltérképezéséhez több erőforrásra van szükség, a gyorsan és könnyen elérhető és olvasható webhelyek javára.

Miért kellene a ChatGPT-nek pazarolnia az erőforrásokat a lassú webhelyek feltérképezésére, ha sokkal kevesebb gonddal képes kinyerni ugyanazokat vagy hasonló információkat a hatékonyabb webhelyekről?

Az Ön webhelye már láthatatlan az AI számára?

A fentiek mindegyike azt feltételezi, hogy a mesterséges intelligenciarobot először is hozzáférhet webhelyéhez. Mint kiderült, még ez sem garantált.

Idén júliusban a Cloudflare (a világ egyik legnagyobb tartalomszolgáltató hálózata) alapértelmezés szerint blokkolja az AI feltérképező robotokat. Ez a döntés potenciálisan befolyásolja több millió webhely AI láthatóságát.

A Cloudflare először 2024 szeptemberében adott lehetőséget a webhelytulajdonosoknak az AI-robotok blokkolására, és több mint 1 millió ügyfél döntött így. Az új fizetésenkénti feltérképezési funkció ezt egy lépéssel továbbviszi, lehetővé téve a Cloudflare fizetős felhasználóinak, hogy megválasszák, mely robotokat engedélyezik és milyen feltételekkel.

A különbség azonban az, hogy a mesterséges intelligenciarobotok blokkolása már nem kötelező. Ha azt szeretné, hogy webhelye és tartalma látható legyen az AI-ban, le kell iratkoznia; persze feltéve, hogy tisztában van a változásokkal.

Ha webhelye Cloudflare infrastruktúrán fut, és nemrégiben nem ellenőrizte kifejezetten a beállításait, akkor megfelelő esély van arra, hogy webhelye most láthatatlan lesz a ChatGPT, a Claude és a Perplexity számára. Nem azért, mert a tartalom nem elég jó. Nem azért, mert gyenge a technikai SEO. Hanem azért, mert egy harmadik féltől származó platform olyan infrastrukturális döntést hozott, amely közvetlenül befolyásolja az Ön láthatóságát, és Ön talán nem is tudja, hogy megtörtént.

Ezzel a kényelmetlen valósággal kell szembenézniük a KPSZ-nek: nem feltételezheted, hogy ami ma működik, az holnap is működni fog. Nem is feltételezheti, hogy a mesterséges intelligencia láthatóságát befolyásoló döntések mindig a szervezeten belül fognak megtörténni.

És amikor egy ilyen változás megtörténik, egyáltalán nem feltételezheti, hogy valaki más kezeli.

Ki a felelős?

A legtöbb technikai SEO-probléma megoldást talál, de először is tisztában kell lennie a problémával. Ehhez két dolog kell:

- Valaki, aki felelős ezeknek a problémáknak az azonosításáért és kiemeléséért.

- Valaki, aki rendelkezik a szükséges készségekkel és szakértelemmel a javításukhoz.

Így megfogalmazva a véleményem kissé patronálónak tűnhet. De légy őszinte, meg tudnád nevezni a szervezetedben ezekért felelős személy(eke)t? Ön szerint ki a felelős azért, hogy proaktívan és autonóm módon azonosítsa és megerősítse Önnel a Cloudflare új feltérképezésenkénti fizetési szabályzatát? És egyetértenek-e az elvárásaiddal, ha megkérdeznéd őket?

Ja, és ne próbálja ki magát azzal, hogy azt állítja, hogy a felelősség a külső SEO-partnereit terheli. Az ügynökségek proaktívan tanácsot adhatnak az ügyfeleknek, ha „jelentős zavarok vannak az Erőben”, például egy függőben lévő Google-frissítés. De a velük kötött szerződés magában foglalja az infrastruktúra minden aspektusának figyelemmel kísérését, beleértve a harmadik féltől származó szolgáltatásokat is? És ez a felelősség kiterjed a mesterséges intelligencia láthatóságának javítására a szokásos SEO tevékenységek mellett? Hacsak nincs kifejezetten megjelölve, nincs okunk feltételezni, hogy aktívan biztosítják, hogy a különféle mesterséges intelligenciarobotok hozzáférjenek webhelyéhez.

Röviden, a legtöbb technikai SEO adósság azért történik, mert mindenki azt feltételezi, hogy valaki másnak a feladata.

A KPSZ vállalja, hogy ez a fejlesztő felelőssége. Ez mind kód, igaz? A fejlesztőknek tudniuk kell, hogy a webhelynek rangsorolnia kell a keresésben, és láthatónak kell lennie az AI-ban. Minden bizonnyal alapértelmezés szerint bevezetik a technikai SEO legjobb gyakorlatát.

De a fejlesztők ugyanúgy nem technikai SEO szakértők, mint webdesignerek vagy UX szakértők. Megépítik, amit megépítenek. Azt fogják előnyben részesíteni, amit te mondasz nekik, hogy helyezzék előtérbe.

Ennek eredményeként a fejlesztőcsapat azt feltételezi, hogy a keresőoptimalizálási csapat feladata az új technikai változtatások megjelölése. A keresőoptimalizálási csapat azonban azt feltételezi, hogy minden rendben van, mert az elmúlt negyedévi műszaki ellenőrzés, amely ugyanazon az ellenőrzési listán alapult, amelyre évek óta támaszkodtak, nem talált semmi rosszat. És mindenki azt feltételezi, hogy ha bármilyen probléma adódna az AI láthatóságával, akkor ezt már valaki más vetette volna fel.

Ez a zavar mind elősegíti a technikai adósság felhalmozódását, láthatatlanul és ellenőrizetlenül.

→ Bővebben: Miért nem működik a SEO, és ez nem a csapat hibája

Hagyd abba a feltételezést, és kezdj el tenni

A legjobb alkalom arra, hogy megakadályozzuk, hogy a fehér hangyák felfalják otthona falait, még mielőtt észrevennénk, hogy ott vannak. Várja meg, amíg a problémák nyilvánvalóvá válnak, és az összes kár kijavításának költsége jóval meghaladja az első ellenőrzés és néhány óvintézkedés költségeit.

Ugyanígy ne várja meg, amíg nyilvánvalóvá válik, hogy márkájának láthatósága az AI-ban veszélybe kerül. Most végezze el a szükséges ellenőrzéseket. Azonosítsa és javítsa ki azokat a műszaki problémákat, amelyek problémákat okozhatnak a mesterséges intelligencia feltérképező robotjai számára.

Ennek nagy része a csapatok közötti erős kommunikáció lesz, olyan felelősségvállalással, amely egyértelművé teszi, hogy ki a felelős az egyes tényezők megfigyeléséért és cselekvéséért, amelyek hozzájárulnak az Ön általános láthatóságához az AI-ban.

Ellenkező esetben minden befektetés és erőfeszítés, amelyet csapata a márkatartalom mesterséges intelligencia számára történő optimalizálására fordít, kárba veszhet.

Ne feltételezd, hogy a holnap úgy fog működni, mint a mai. A SEO technikai adóssága hatással lesz az AI láthatóságára. Ez nem vita tárgya. Az igazi kérdés az, hogy proaktívan kezeli-e technikai SEO-tartozását most, vagy megvárja, amíg a feltételezések hatására az online láthatóság összeomlik.