Az információkereső rendszereket úgy alakították ki, hogy a felhasználók elégedettek legyenek. Hogy a felhasználó elégedett legyen a visszahívás minőségével. Fontos, hogy ezt megértsük. Minden rendszer és annak bemenetei és kimenetei a legjobb felhasználói élményt biztosítják.

Az edzési adatoktól a hasonlósági pontozásig és a gép azon képességéig, hogy „megérti” fáradt, szomorú baromságunkat – ez a harmadik a sorozatban, amelynek címe: Információkeresés hülyéknek.

TL;DR

- A vektortér modellben a vektorok közötti távolság a dokumentumok vagy tételek közötti relevanciát (hasonlóságot) jelenti.

- A vektorizálás lehetővé tette a keresőmotorok számára, hogy a szókeresés helyett fogalmak keresését végezzék. Ez a fogalmak összehangolása, nem a betűk vagy szavak.

- A hosszabb dokumentumok több hasonló kifejezést tartalmaznak. Ennek leküzdésére a dokumentum hosszát normalizálják, és a relevanciát prioritásként kezelik.

- A Google több mint egy évtizede csinálja ezt. Talán több mint egy évtizede, neked is.

Amit tudnod kell, mielőtt elkezdenénk

Néhány fogalom és rendszer, amivel tisztában kell lennie, mielőtt belemerülünk.

Nem emlékszem mindezekre, és te sem fogsz. Csak próbálja meg élvezni magát, és remélje, hogy az ozmózis és a következetesség révén idővel homályosan emlékszik a dolgokra.

- TF-IDF a frekvencia-inverz dokumentumgyakoriság kifejezést jelenti. Ez egy numerikus statisztika, amelyet az NLP-ben és az információkeresésben használnak egy kifejezés relevanciájának mérésére a dokumentumkorpuszon belül.

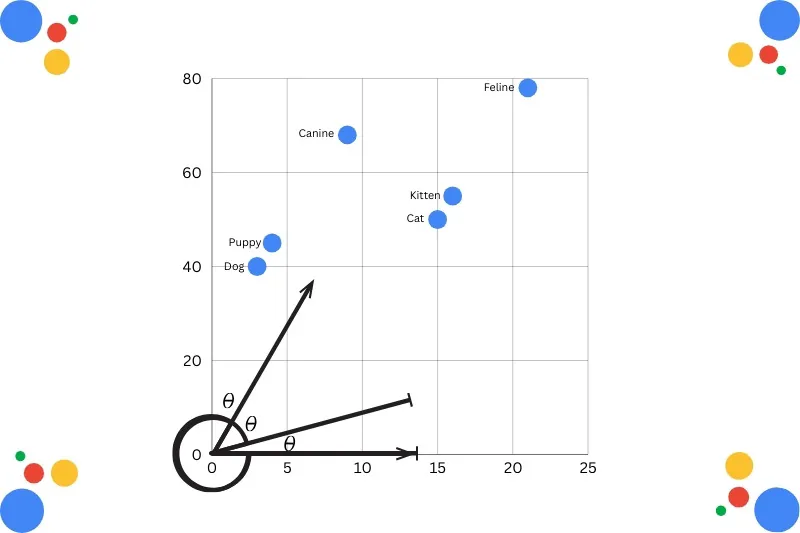

- Koszinusz hasonlóság két vektor közötti szög koszinuszát méri, -1 és 1 között. A kisebb szög (közelebb az 1-hez) nagyobb hasonlóságot jelent.

- A zsákos szavak modellje a szöveges adatok megjelenítésének módja a szöveg gépi tanulási algoritmusokkal történő modellezésekor.

- Funkció kivonás/A kódolási modellek a nyers szöveget numerikus reprezentációkká alakítják, amelyeket gépi tanulási modellekkel lehet feldolgozni.

- Euklideszi távolság méri a vektortér két pontja közötti egyenes távolságot az adatok hasonlóságának (vagy eltérésének) kiszámításához.

- Doc2Vec (a Word2Vec kiterjesztése), amelyet arra terveztek, hogy a dokumentumokban a hasonlóságot (vagy annak hiányát) ábrázolja a szavakkal szemben.

Mi az a vektoros térmodell?

A vektortérmodell (VSM) egy algebrai modell, amely szöveges dokumentumokat vagy elemeket „vektorokként” ábrázol. Ez az ábrázolás lehetővé teszi a rendszerek számára, hogy távolságot hozzanak létre az egyes vektorok között.

A távolság kiszámítja a kifejezések vagy elemek közötti hasonlóságot.

Az információkeresésben, a dokumentumok rangsorolásában és a kulcsszavak kinyerésében általánosan használt vektoros modellek struktúrát hoznak létre. Ez a strukturált, nagy dimenziójú numerikus tér lehetővé teszi a relevancia kiszámítását hasonlósági mértékek, például koszinusz-hasonlóság segítségével.

A kifejezések hozzárendelt értékek. Ha egy kifejezés szerepel a dokumentumban, annak értéke nem nulla. Érdemes megjegyezni, hogy a kifejezések nem csak egyéni kulcsszavak. Lehetnek kifejezések, mondatok és teljes dokumentumok.

Miután a lekérdezésekhez, kifejezésekhez és mondatokhoz értékeket rendeltek, a dokumentum pontozható. Fizikai helye van a vektortérben a modell által kiválasztott módon.

Pontozása alapján a bevitt lekérdezés alapján a dokumentumok összehasonlíthatók egymással. Hasonlósági pontszámokat generál skálán. Ezt szemantikai hasonlóságnak nevezik, amikor a dokumentumok egy halmazát pontozzák és elhelyezik az indexben azok alapján jelentése.

Nem csak a lexikális hasonlóságukat.

Tudom, hogy ez egy kicsit bonyolultan hangzik, de gondolj a következőre:

Az oldalon lévő szavak manipulálhatók. Kulcsszó töltött. Túl egyszerűek. De ha ki tudja számítani (a dokumentum jelentését), akkor egy lépéssel közelebb kerül a minőségi kimenethez.

Miért működik olyan jól?

A gépek nem csak a szerkezetet szeretik. Rohadtul szeretik.

A rögzített hosszúságú (vagy stílusos) bemenetek és kimenetek kiszámítható, pontos eredményeket hoznak létre. Minél informatívabb és kompaktabb egy adatkészlet, annál jobb minőségi osztályozást, kinyerést és előrejelzést kap.

A szöveggel az a probléma, hogy nincs sok szerkezete. Legalábbis nem egy gép szemében. Ez rendetlen. Ezért van ekkora előnye a klasszikus Boolean Retrieval Modellel szemben.

A logikai lekérdezési modellekben a dokumentumok az alapján kerülnek lekérésre, hogy megfelelnek-e egy logikai logikát használó lekérdezés feltételeinek. Minden dokumentumot szavak vagy kifejezések halmazaként kezel, és az ÉS, VAGY és NEM operátorokat használja az összes olyan eredmény visszaadásához, amely megfelel a számlának.

Az egyszerűségének megvan a maga haszna, de nem tudja értelmezni a jelentését.

Tekintsd inkább adatvisszakeresésnek, mint információ azonosításnak és értelmezésnek. Az árnyaltabb keresésekkel túl gyakran esünk bele a frekvencia (TF) csapdájába. Könnyű, de lusta a mai világban.

Míg a vektortér-modell értelmezi a lekérdezés tényleges relevanciáját, és nem igényel pontos egyezési kifejezéseket. Ez a szépsége.

Ez a szerkezet sokkal pontosabb felidézést hoz létre.

A transzformátorok forradalma (nem Michael Bay)

Michael Bay sorozatával ellentétben a igazi A transzformátor architektúra a régebbi, statikus beágyazási módszereket (például Word2Vec) kontextuális beágyazásokkal váltotta fel.

Míg a statikus modellek minden szóhoz egy vektort rendelnek, a transzformátorok dinamikus reprezentációkat generálnak, amelyek a mondatban lévő környező szavak alapján változnak.

És igen, a Google már egy ideje ezt csinálja. Ez nem új. Ez nem GEO. Csak a modern információkeresés „megért” egy oldalt.

Úgy értem, nyilván nem. De te, mint remélhetőleg érző, lélegző lény, érted, mire gondolok. De a transzformátorok, hát ők hamisítom:

- A transzformátorok a bevitt adatokat szignifikancia szerint súlyozzák.

- A modell nagyobb figyelmet fordít azokra a szavakra, amelyek extra kontextust igényelnek vagy nyújtanak.

Hadd mondjak egy példát.

– A denevér fogai kivillantak, ahogy kirepült a barlangból.

A denevér kétértelmű kifejezés. A kétértelműség rossz a mesterséges intelligencia korában.

A transzformátor-architektúra azonban összekapcsolja az ütőt a „fogakkal”, a „repült” és a „barlanggal”, jelezve, hogy az ütő sokkal valószínűbb, hogy vérszívó rágcsáló*, mint valami olyasvalami, amellyel egy úriember simogatja a labdát a világ legjobb sportjában.

* Fogalmam sincs, hogy a denevér rágcsáló-e, de úgy néz ki, mint egy szárnyas patkány.

BERT visszavág

BERT. Kétirányú kódoló ábrázolások a Transformerstől. Vállat von.

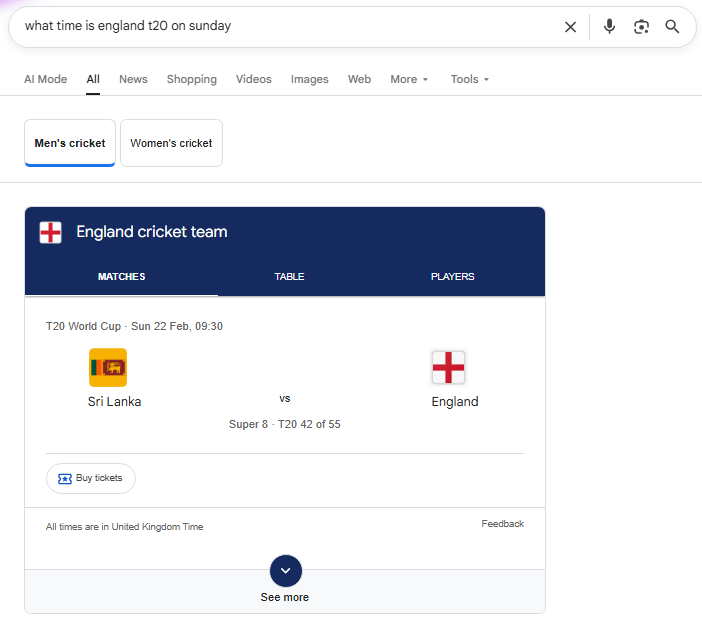

A Google így működik évek óta. Az ilyen típusú kontextuális tudatos megértés alkalmazásával a szavak és dokumentumok közötti szemantikai kapcsolatokra. Ez nagyrészt annak köszönhető, hogy a Google miért olyan jó a szándékok feltérképezésében és megértésében, és hogyan változik az idő múlásával.

A BERT újabb frissítései (DeBERTa) lehetővé teszik a szavak két vektorral történő ábrázolását – az egyik a jelentést, a másik pedig a dokumentumban elfoglalt helyét. Ez az úgynevezett Disentangled Attention. Pontosabb kontextust biztosít.

Igen, nekem is furcsán hangzik.

A BERT a teljes szósorozatot egyidejűleg dolgozza fel. Ez azt jelenti, hogy a kontextust az oldal teljes tartalmából alkalmazzák (nem csak a környező néhány kifejezést).

Szinonimák Baby

A 2015-ben elindított RankBrain volt a Google első mély tanulási rendszere. Nos, amit egyébként tudok. Úgy tervezték, hogy segítse a keresési algoritmust megérteni, hogyan kapcsolódnak a szavak a fogalmakhoz.

Ez egyfajta keresési csúcskorszak volt. Bárki indíthat weboldalt bármiről. Hozd fel és rangsorolj. Keress egy rakás pénzt. Nem kell semmiféle szigor.

Halcyon napok.

Utólag visszagondolva, ezek a napok nem voltak jók a szélesebb nyilvánosság számára. Tanácsot kaphat a temetéstervezéssel és a kereskedelmi hulladékkezeléssel kapcsolatban egy 23 éves halifaxi foltos hálószobából.

Ahogy az új és fejlődő lekérdezések felpörögtek, a RankBrain és az azt követő neurális egyeztetés létfontosságú volt.

Aztán ott volt MUM. A Google képes „megérteni” szöveget, képeket és vizuális tartalmat több nyelven egyszerre.

A dokumentum terjedelme nyilvánvaló probléma volt 10 évvel ezelőtt. Talán kevésbé. A hosszabb cikkek, jóban vagy rosszban, mindig jobban teljesítettek. Emlékszem, 10 000 szavas cikkeket írtam a webhelykészítőkről szóló hülyeségekről, és felragasztom őket egy kezdőlapra.

Már akkor is hülye ötlet volt…

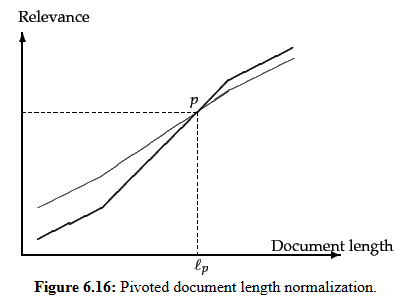

Egy olyan világban, ahol a lekérdezések és dokumentumok számokhoz vannak rendelve, megbocsátható, ha azt gondolja, hogy a hosszabb dokumentumok mindig a rövidebbek fölé kerülnek.

Emlékezz 10-15 évvel ezelőttre, amikor mindenki megszállott volt, amikor minden cikk 2000 szóból állt.

„Ez az optimális hosszúság a keresőoptimalizáláshoz.”

Ha egy másik, 2000 szavas „Mi az idő X” cikket lát, engedélyem van arra, hogy lelőj.

A hosszabb dokumentumok – a több kifejezést tartalmazó – magasabb TF értékkel rendelkeznek. Különböző kifejezéseket is tartalmaznak. Ezek a tényezők összeesküdve növelhetik a hosszabb dokumentumok pontszámát

Ezért egy ideig ők voltak a gagyi tartalomgyártásunk zenitje.

A hosszabb dokumentumok nagyjából két kategóriába sorolhatók:

- Bőbeszédű dokumentumok, amelyek lényegében ugyanazt a tartalmat ismétlik (helló, kulcsszótömés, régi barátom).

- Több témát lefedő dokumentumok, amelyekben a keresőkifejezések valószínűleg a dokumentum kis szegmenseire egyeznek, de nem az egészre.

Ennek a nyilvánvaló problémának a leküzdésére a dokumentum hosszának kompenzációját alkalmazzák, az úgynevezett Pivoted Document Length Normalization néven. Ez úgy módosítja a pontszámokat, hogy ellensúlyozza a hosszabb dokumentumok természetes torzítását.

A koszinusz távolságot azért érdemes használni, mert nem a hosszabb (vagy rövidebb) dokumentumokat szeretnénk előnyben részesíteni, hanem a relevanciára koncentrálunk. Ennek a normalizálásnak a kihasználása a relevanciát helyezi előtérbe a kifejezés gyakoriságával szemben.

Ezért olyan értékes a koszinusz hasonlóság. Robusztus a dokumentumhosszúsághoz. Egy rövid és hosszú válasz akkor tekinthető topikálisan azonosnak, ha a vektortérben azonos irányba mutat.

Remek kérdés.

Nos, senki sem várja el tőled, hogy megértsd a vektoros adatbázisok bonyolultságát. Nem igazán kell tudnia, hogy az adatbázisok speciális indexeket hoznak létre a közeli kereséshez szomszédok minden egyes rekord ellenőrzése nélkül.

Ez csak a Google-hoz hasonló cégek számára készült, hogy megtalálják a megfelelő egyensúlyt a teljesítmény, a költségek és a működési egyszerűség között.

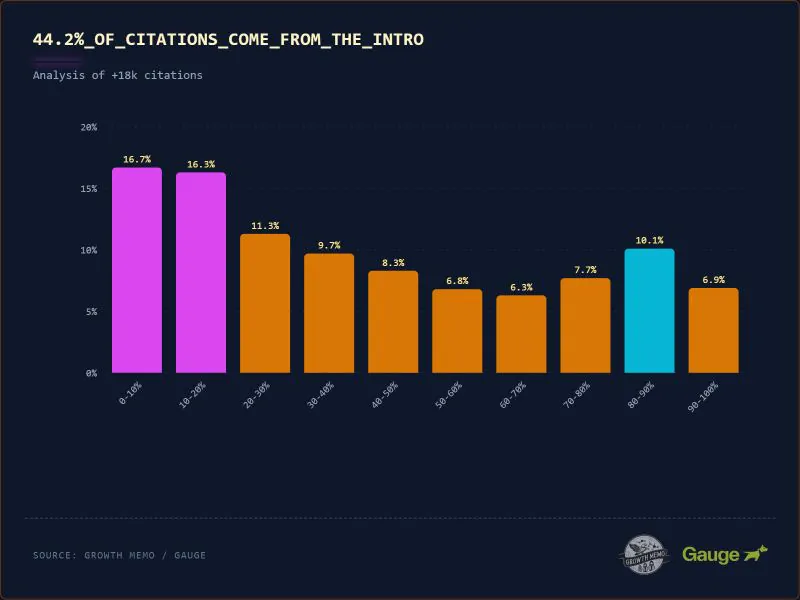

Kevin Indig legújabb kiváló kutatása azt mutatja, hogy a ChatGPT összes idézetének 44,2%-a a szöveg első 30%-ából származik. Az idézés valószínűsége jelentősen lecsökken ezen kezdeti szakasz után, ami „sírámpát” hoz létre.

Még több ok arra, hogy ne hozzon létre ész nélkül hatalmas dokumentumokat, mert valaki azt mondta.

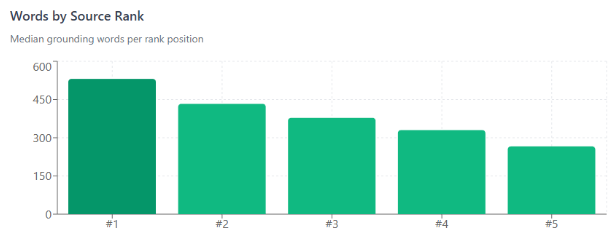

Az „AI-keresésben” sok minden a tokenekre vezethető vissza. Dan Petrovic mindig kiváló munkája szerint minden lekérdezés fix, összesen körülbelül 2000 szóból áll, amely a források között relevancia szerint van elosztva.

A Google-ban legalábbis. És a rangod határozza meg a pontszámod. Tehát kezdjen SEO-val.

Metehan tanulmánya arról, hogy mit árul el 200 000 token az AEO/GEO-ról, igazán rávilágít ennek fontosságára. Vagy lesz. Nem csak a munkánk miatt, hanem az elfogultságok és a kulturális vonatkozások miatt is.

Mivel a szöveget tokenizálják (tömörítik és egész számú azonosítók sorozatává alakítják), ennek költség- és pontossági következményei vannak.

- Az egyszerű angol próza a leginkább token-hatékony formátum, tokenenként 5,9 karakter. Nevezzük 100%-os relatív hatékonyságnak. Egy alapvonal.

- A török prózában mindössze 3,6. Ez 61%-ban hatékony.

- Leértékelési táblázatok 2.7. 46%-a olyan hatékony.

A nyelvek nem egyenlőek. Egy olyan korszakban, amikor a tőkekiadások (CapEx) költségei szárnyalnak, és az AI-cégek üzleteket kötöttek, nem vagyok benne biztos, hogy készpénzt tudnak fizetni, ez számít.

Nos, mivel a Google már egy ideje ezt csinálja, ugyanazoknak a dolgoknak kell működniük mindkét felületen.

- Válaszolj az átgondolt kérdésre. istenem. Térj a lényegre. Nem érdekel semmi más, mint amit akarok. Azonnal add ide (emberként és gépként beszélve).

- Tehát előre küldje el fontos információit. nincs figyelmem. A transzformátormodellek sem.

- Egyértelművé tenni. Entitásoptimalizálási munka. Csatlakoztassa a pontokat online. Igényelje tudáspaneljét. Szerzők, közösségi fiókok, strukturált adatok, márkák és profilok építése.

- Kiváló EEAT. Megbízható információkat nyújtson olyan módon, amely megkülönbözteti Önt a versenytársaktól.

- Hozzon létre kulcsszavakban gazdag belső hivatkozásokat, amelyek segítenek meghatározni, miről szól az oldal és a tartalom. Rész egyértelműsítése. Részben csak jó UX.

- Ha azt szeretné, hogy valami az LLM-ekre összpontosítson, legyen hatékonyabb a szavaival.

- A strukturált listák használatával 20-40%-kal csökkenthető a tokenfogyasztás, mert eltávolítják a szöszöket. Nem azért, mert hatékonyabbak*.

- A tokenek mentéséhez is használjon általánosan ismert rövidítéseket.

*Érdekes módon kevésbé hatékonyak, mint a hagyományos próza.

Szinte mindez arról szól, hogy gyorsan megadjuk az embereknek azt, amit akarnak, és minden kétértelműséget elhárítunk. Egy szarokkal teli interneten ez tényleg működik.

Utolsó darabok

Vita folyik arról, hogy az ügynökök leértékelése segíthet-e eltávolítani a HTML szöszmöt a webhelyén. Így az ügynökök megkerülhetik a zsúfolt HTML-t, és egyenesen a jó dolgokhoz.

Hogy ezt mennyit lehetne megoldani a szemantikus HTML kevésbé elbaszott megközelítésével, nem tudom. Mindenesetre egy néznivaló.

Nagyon SEO. Sok AI.

Olvassa el: Vezetés a SEO-ban. Iratkozz fel most.