Növelje készségeit a Growth Memo heti szakértői betekintéseivel. Iratkozz fel ingyen!

E heti eredményeim azt mutatják, hogy a Google Search Console adatai körülbelül 75%-ban hiányosak, ami veszélyesen megbízhatatlanná teszi az egyforrású GSC-döntéseket.

1. A GSC régen az igazság alapja volt

A Search Console-adatok korábban a legpontosabban reprezentálták azt, ami a keresési eredmények között történik. De az adatvédelmi mintavételezés, a botokkal felfújt megjelenítések és az AI Áttekintés (AIO) torzítása kiszívja az adatok megbízhatóságát.

Az adatok szűrésének és torzításának megértése nélkül fennáll annak a veszélye, hogy rossz következtetéseket von le a GSC adataiból.

A SEO-adatok hosszú utat jártak be a kevésbé megbízhatóvá válás felé, kezdve azzal, hogy a Google megöli a kulcsszó-hivatkozót, egészen a kritikus SERP-funkciók kizárásáig a teljesítményeredmények közül. De az elmúlt 12 hónap három kulcsfontosságú eseménye tetézte:

- 2025. január: A Google a „SearchGuard”-ot telepíti, amely JavaScriptet és (kifinomult) CAPTCHA-t igényel mindenki számára, aki a keresési eredményeket nézi (kiderült, hogy a Google sok fejlett jelet használ az emberek megkülönböztetésére a kaparóktól).

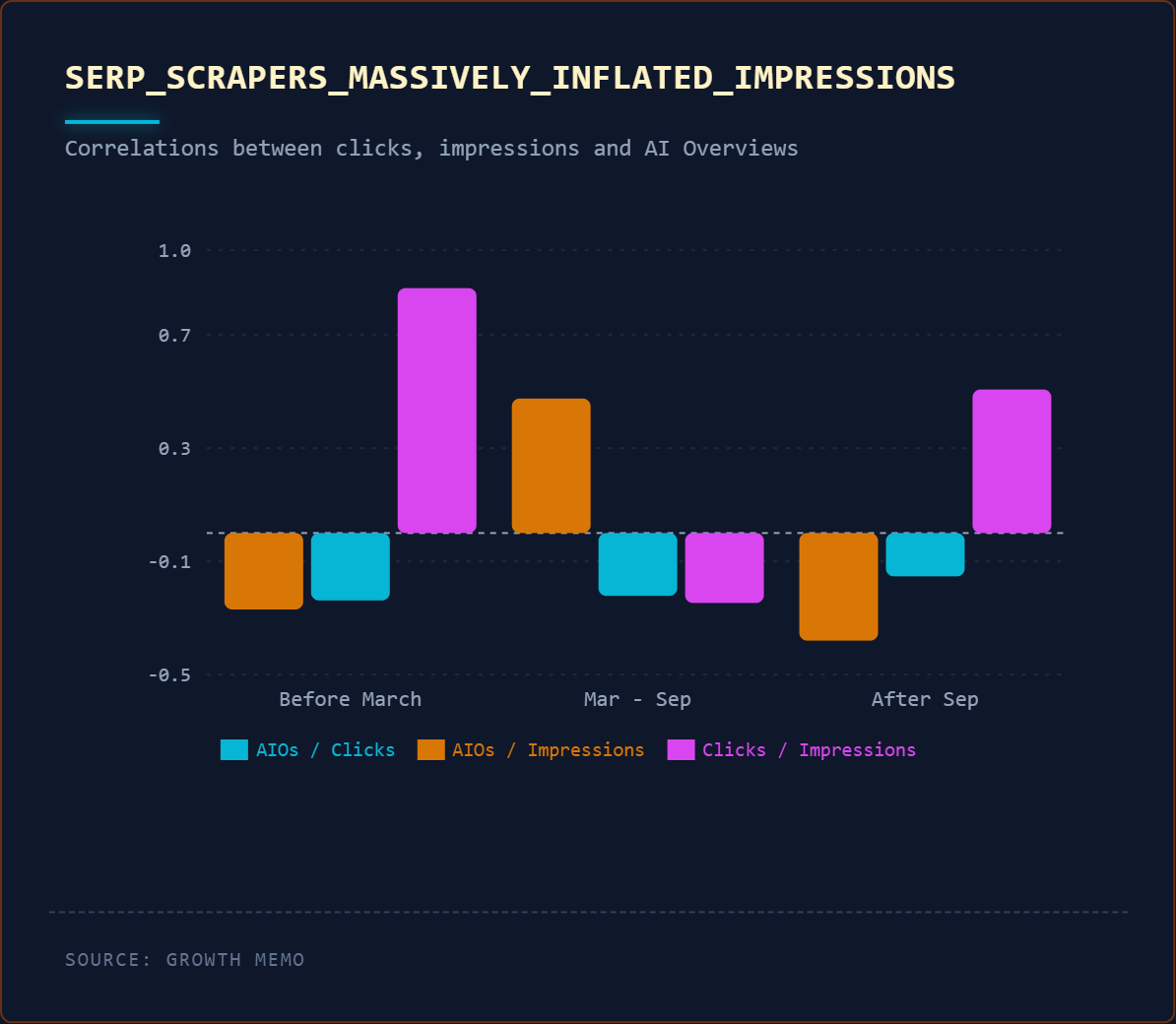

- 2025. március: A Google jelentősen megnöveli az AI áttekintések számát a SERP-ekben. Jelentős kiugrást tapasztalunk a megjelenítések és a kattintások számában.

- 2025. szeptember: A Google eltávolítja a num=100 paramétert, amelyet a SERP kaparók használnak a keresési eredmények elemzéséhez. A megjelenítési csúcs normalizálódik, a kattintások száma csökken.

Egyrészt a Google intézkedéseket tett a GSC-adatok megtisztítására. Másrészt az adatok továbbra is több nyitott kérdést hagynak bennünk, mint válaszokat.

2. Az adatvédelmi mintavétel a lekérdezések 75%-át elrejti

A Google „adatvédelmi okokból” jelentős mennyiségű megjelenítést (és kattintást) szűr ki. Egy évvel ezelőtt Patrick Stox egy nagy adathalmazt elemzett, és arra a következtetésre jutott, hogy majdnem 50%-a ki van szűrve.

Megismételtem az elemzést (10 B2B webhely az USA-ban) ~4 millió kattintás és ~450 millió megjelenítés tekintetében.

Módszertan:

- A Google Search Console (GSC) két API-végponton keresztül szolgáltat adatokat, amelyek felfedik szűrési viselkedését. Az összesített lekérdezés (nincs dimenzió) az összes kattintást és megjelenítést adja vissza, beleértve az összes adatot. A lekérdezésszintű lekérdezés („lekérdezés” dimenzióval) csak a Google adatvédelmi küszöbét teljesítő lekérdezéseket adja vissza.

- A két szám összehasonlításával kiszámíthatja a szűrési arányt.

- Ha például az összesített adatok 4205 kattintást mutatnak, de a lekérdezési szintű adatok csak 1937 látható kattintást mutatnak, a Google 2268 kattintást szűrt (53,94%).

- 10 B2B SaaS webhelyet elemeztem (~4 millió kattintás, ~450 millió megjelenítés), összehasonlítva a 30 napos, 90 napos és 12 hónapos időszakokat az előző 12 hónap azonos elemzésével.

Az én következtetésem:

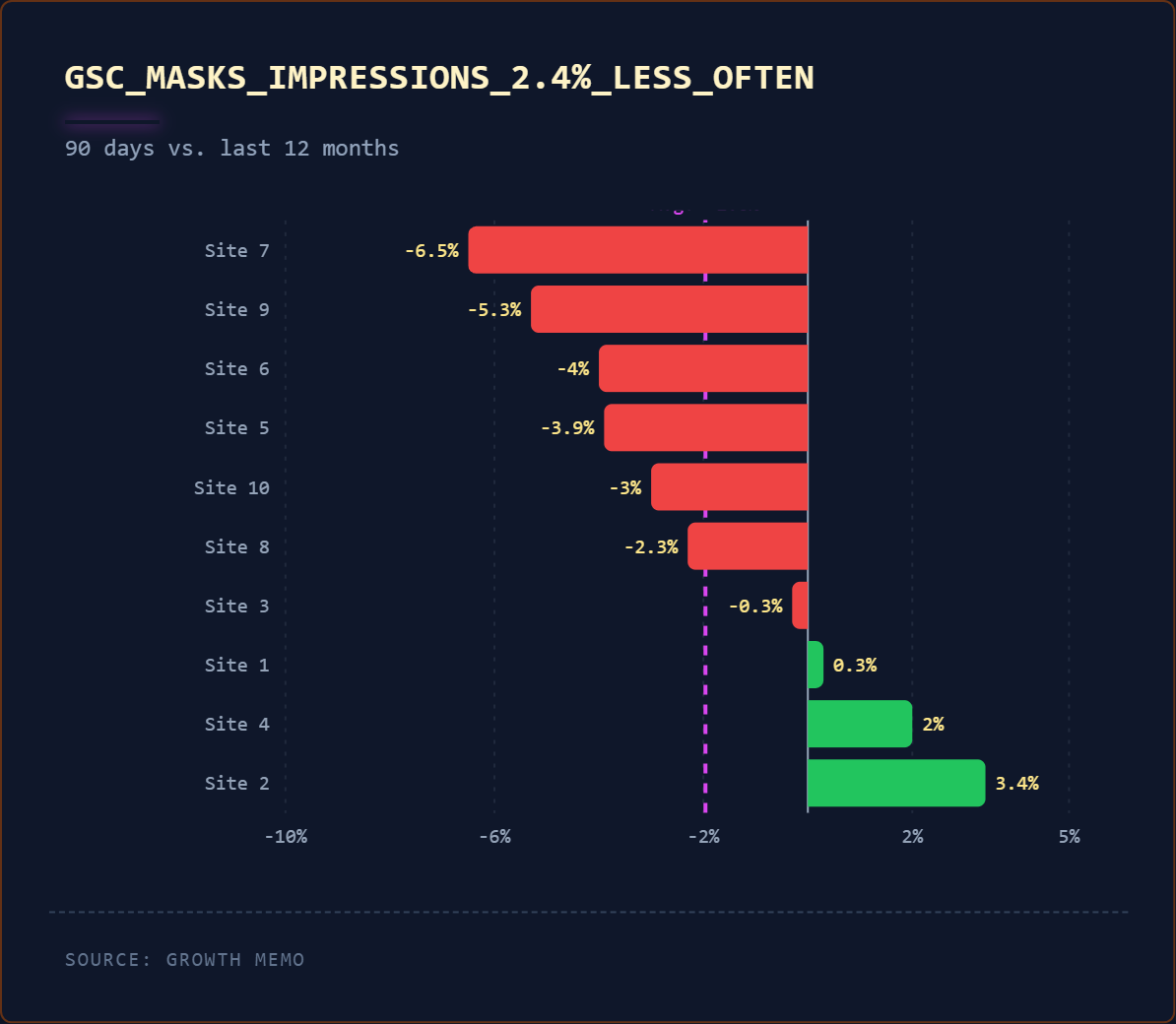

1. A Google a megjelenítések ~75%-át szűri ki.

- A megjelenítések szűrési aránya hihetetlenül magas, az adatvédelem érdekében a háromnegyedét szűrjük.

- 12 hónappal ezelőtt ez az arány mindössze 2 százalékponttal volt magasabb.

- Az általam megfigyelt tartomány 59,3%-ról egészen 93,6%-ra emelkedett.

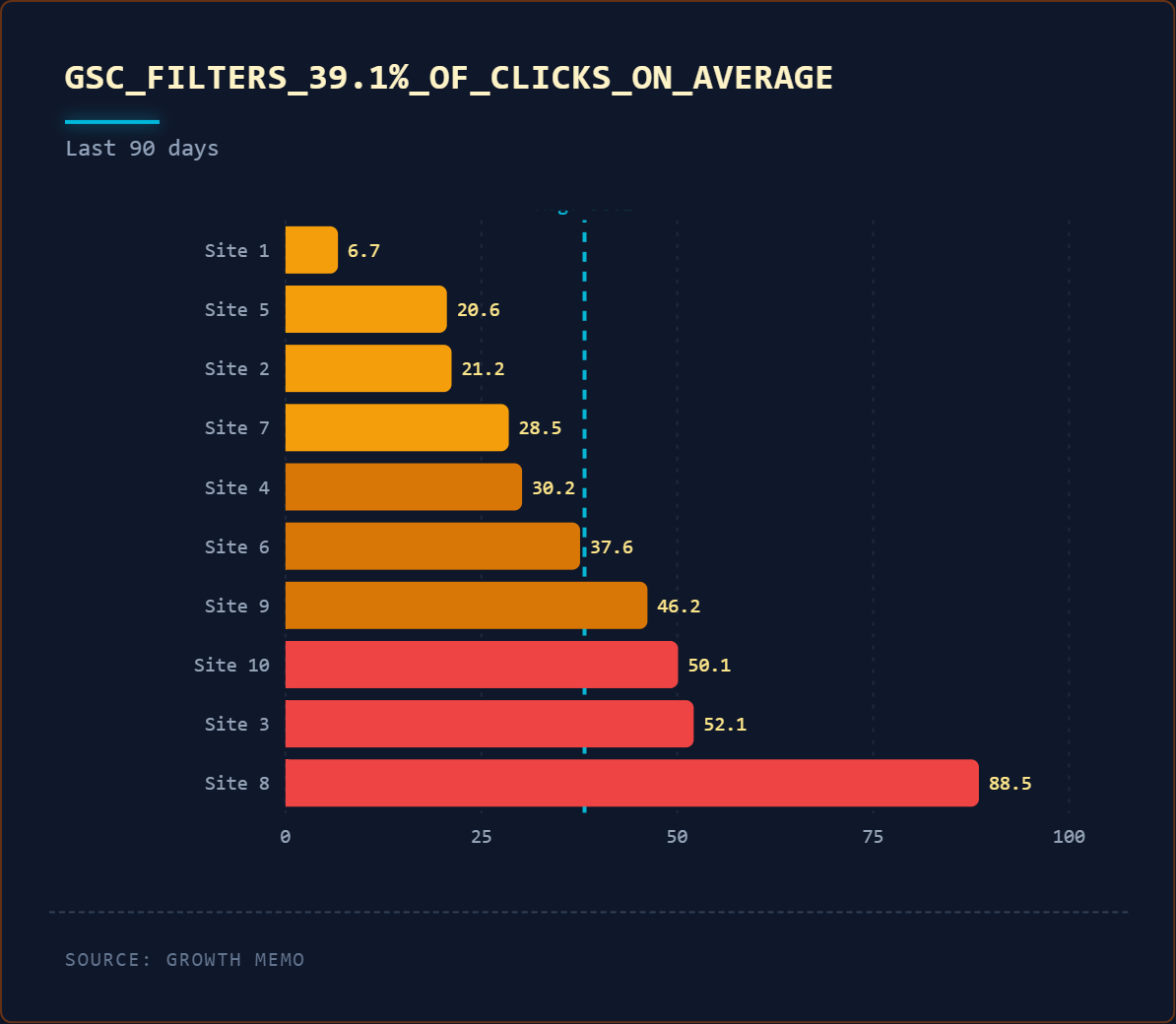

2. A Google a kattintások ~38%-át szűri ki, de ~5%-kal kevesebbet, mint 12 hónappal ezelőtt.

- A kattintásszűrésről nem beszélünk sokat, de úgy tűnik, a Google nem jelenti az összes kattintás egyharmadát.

- 12 hónappal ezelőtt a Google a kattintások több mint 40%-át kiszűrte.

- A szűrési tartomány 6,7%-tól 88,5%-ig terjed!

A jó hír az, hogy a szűrési arány enyhén csökkent az elmúlt 12 hónapban, valószínűleg a kevesebb „botmegjelenítés” miatt.

A rossz hír: az alapvető probléma továbbra is fennáll. Még ezekkel a fejlesztésekkel is katasztrofálisan magas marad a 38%-os kattintásszűrés és 75%-os megjelenítési szűrés. Az 5%-os javulás nem teszi megbízhatóvá az egyetlen forrásból származó GSC-döntéseket, ha a megjelenítési adatok háromnegyede hiányzik.

3. A 2025-ös benyomások nagyon megnövekednek

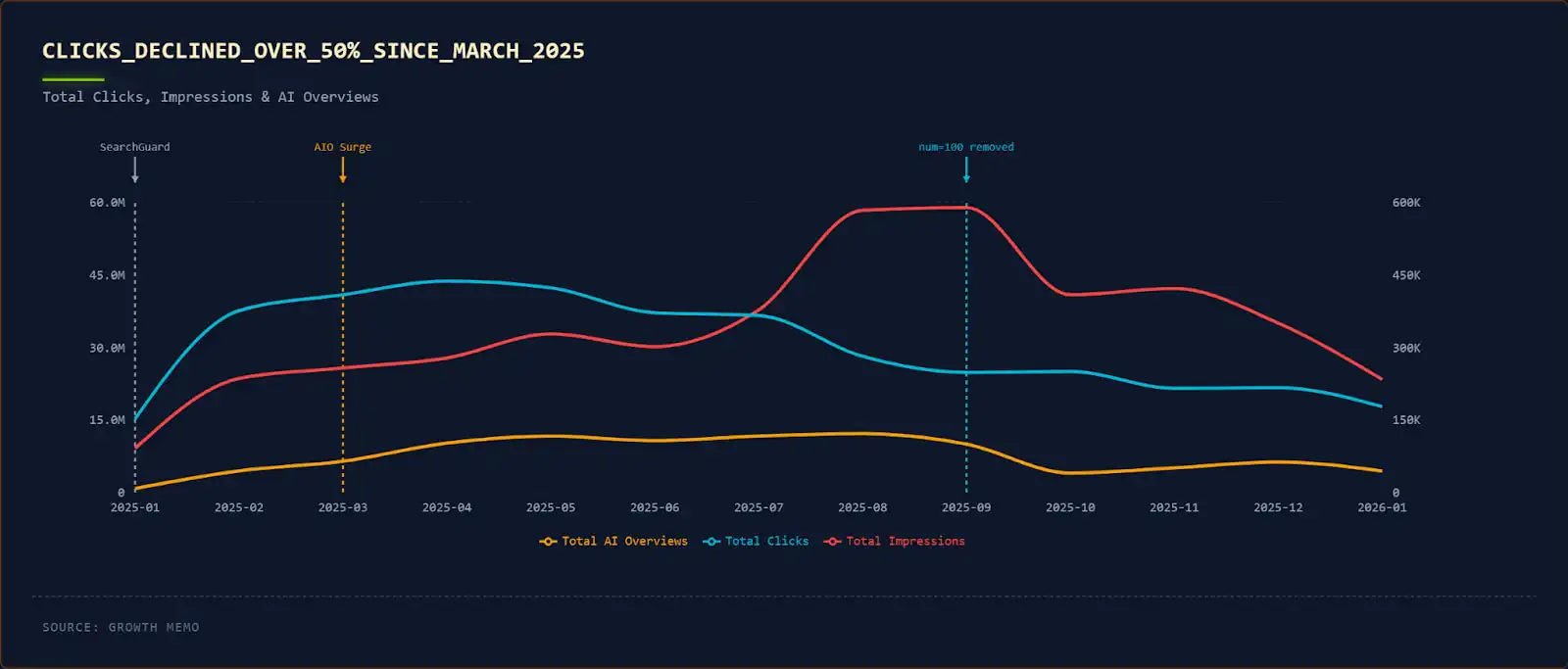

Az elmúlt 12 hónap a GSC-adatok hullámvasútját mutatja:

- 2025 márciusában a Google fokozta az AIO-k bevezetését, és 58%-kal többet mutatott be az általam elemzett webhelyeken.

- Júliusban a megjelenítések száma 25,3%-kal, augusztusban pedig további 54,6%-kal nőtt. A SERP-kaparók valahogy megtalálták a módját a SearchGuard (a Google által a SERP-kaparók megakadályozására használt védelmi „bot”) megkerülésének, és „bot-benyomásokat” okoztak az AIO-k rögzítésére.

- Szeptemberben a Google eltávolította a num=100 paramétert, ami miatt a megjelenítések száma 30,6%-kal csökkent.

Gyorsan előre a mai napra:

- A kattintások száma 56,6%-kal csökkent 2025 márciusa óta.

- A megjelenítések normalizálódtak (-9,2%).

- Az AIO-k 31,3%-kal csökkentek.

Az AIO-k által leadott kattintások ok-okozati számát nem tudom megállapítani, de a korreláció erős: 0,608. Tudjuk, hogy az AIO-k csökkentik a kattintásokat (logikailag logikus), de nem tudjuk pontosan, hogy mennyit. Ennek kiderítéséhez mérnem kell a lekérdezések CTR-jét az AIO megjelenése előtt és után.

De honnan tudod, hogy a kattintások csökkenése az AIO-nak köszönhető, nem csak a rossz tartalomminőségnek vagy a tartalom hanyatlásának?

Keresse az időbeli összefüggést:

- Kövesse nyomon, hogy mikor csökkent a kattintások száma a Google AIO bevezetési idővonalához képest (2025. márciusi csúcs). A rossz tartalomminőség fokozatos hanyatlást mutat; Az AIO hatás éles és lekérdezésspecifikus.

- Kereszthivatkozás pozícióadatokkal. Ha a helyezések stabilak, miközben a kattintások száma csökken, az AIO kannibalizációt jelez. Ellenőrizze, hogy az érintett lekérdezések információs (AIO-ra hajlamos) vagy tranzakciós (AIO-rezisztens) lekérdezések-e. Az AIO jelenléte és a kattintáscsökkentés közötti 0,608-as korrelációs együttható támogatja ezt a diagnosztikai megközelítést.

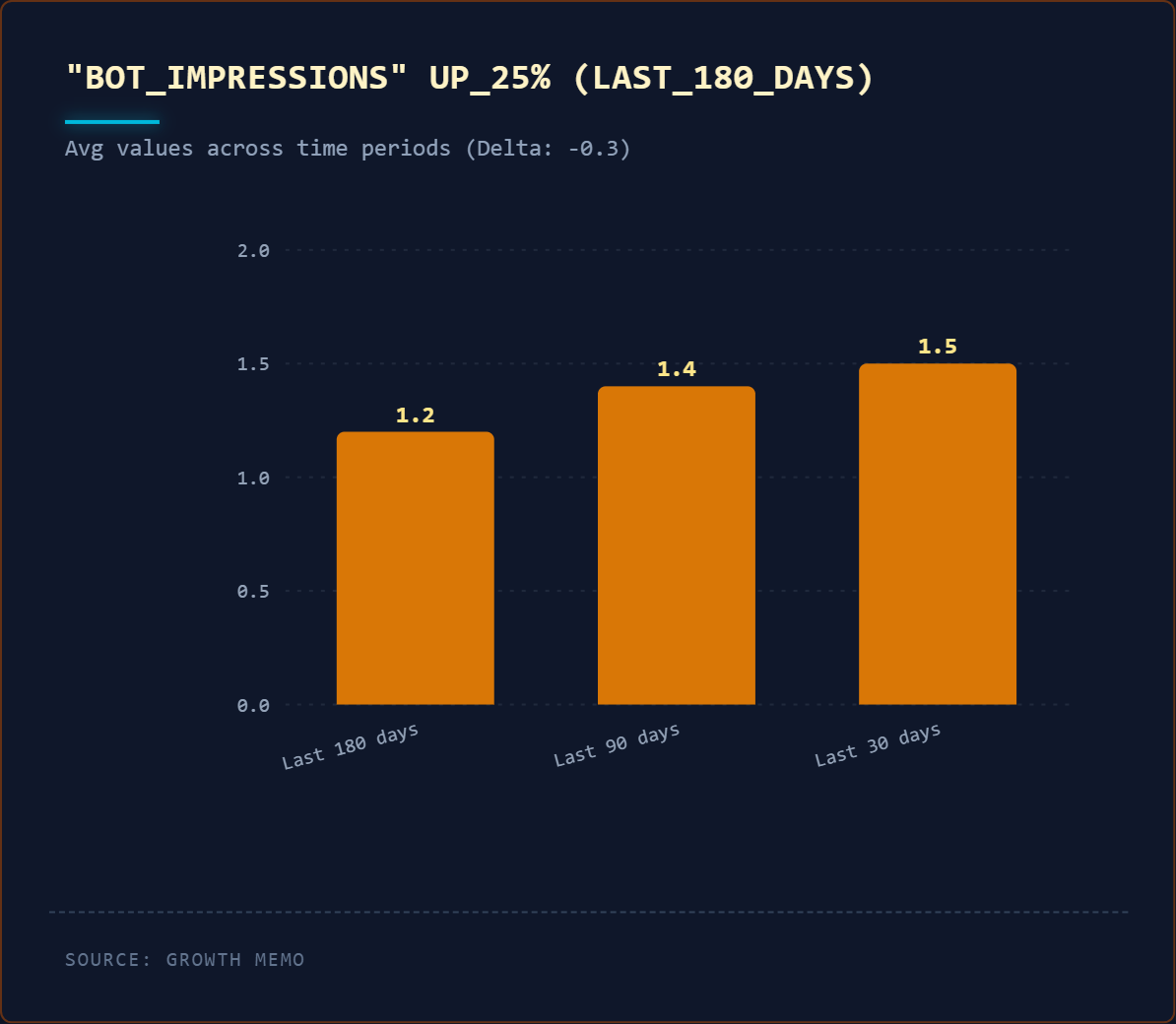

4. A botbenyomások emelkednek

Okom van azt hinni, hogy a SERP kaparók visszatérnek. A botok által valószínűleg okozott megjelenítések mennyiségét úgy tudjuk mérni, hogy kiszűrjük a GSC-adatokat olyan lekérdezések alapján, amelyek több mint 10 szót és két megjelenítést tartalmaznak. Annak az esélye, hogy egy ilyen hosszú lekérdezést (prompt) egy ember kétszer használ, közel nulla.

A bot-megjelenítések logikája:

- Hipotézis: Az emberek ritkán keresnek pontosan ugyanarra az 5+ szóból álló lekérdezésre kétszer egy rövid ablakban.

- Szűrő: Azonosítsa azokat a 10+ szót tartalmazó lekérdezéseket, amelyeknek több mint 1 megjelenítésük van, de nincs kattintás.

- Ellentmondás: Ez a módszer rögzíthet néhány legitim nulla kattintásos lekérdezést, de iránymutató becslést ad a robottevékenységről.

Összehasonlítottam ezeket a lekérdezéseket az elmúlt 30, 90 és 180 nap során:

- A +10 szót és +1 megjelenítést tartalmazó lekérdezések száma 25%-kal nőtt az elmúlt 180 nap során.

- A botmegjelenítések tartománya 0,2% és 6,5% között mozog (az elmúlt 30 napban).

Íme, mire számíthat a botmegjelenítések „normál” százalékában egy tipikus SaaS-webhelyen:

- A 10 webhelyet tartalmazó B2B adatkészlet alapján a botmegjelenítések 0,2% és 6,5% között mozognak 30 nap alatt, 10+ szót és 2+ megjelenítést, de 0 kattintást tartalmazó lekérdezések esetén.

- Kifejezetten a SaaS esetében 1-3%-os alapértékre számítson a botmegjelenítések tekintetében. A kiterjedt dokumentációt, műszaki útmutatókat vagy automatizált keresőoptimalizálási oldalakat tartalmazó webhelyek trendje magasabb (4-6%).

- A 180 nap alatt elért 25%-os növekedés arra utal, hogy a kaparók alkalmazkodnak a SearchGuard után. Az abszolút számnál jobban figyelje a százalékos pozícióját ebben a tartományban.

A robotmegjelenítések nem befolyásolják a tényleges rangsorolást – csak a megjelenítések számának növelésével készített jelentéseit. A gyakorlati hatás? Rosszul kiosztott erőforrások, ha olyan megnövelt megjelenítési lekérdezésekre optimalizál, amelyeket az emberek soha nem keresnek.

5. A mérőréteg megszakadt

A GSC adatokon alapuló, egy forrásból származó döntések veszélyessé válnak:

- A megjelenítések háromnegyedét kiszűri.

- A robotmegjelenítések az adatok akár 6,5%-át is generálják.

- Az AIO-k több mint 50%-kal csökkentik a kattintások számát.

- A felhasználói viselkedés szerkezetileg megváltozik.

Az Ön lehetősége a módszertanban rejlik: Azok a csapatok, amelyek robusztus mérési keretrendszereket (mintavételi gyakorisági szkriptek, bot-megosztási számítások, több forrású háromszögelés) építenek, versenyelőnyben vannak.