A Google Search Central Live APAC 2025 második napja röviden elindult az előző napi mély merüléshez a mászáshoz, mielőtt egyenesen az indexelésbe lépett.

A Cherry Prommawin megnyitotta azáltal, hogy átjárja a Google Parses HTML -t, és kiemeli az indexelés legfontosabb szakaszait:

- HTML elemzés.

- Renderálás és JavaScript végrehajtás.

- Deduplikáció.

- Feature Extraction.

- Jelkivonás.

Ez a nap hátralévő részére meghatározta a témát.

Cherry megjegyezte, hogy a Google először normalizálja a nyers HTML -t DOM -ba, majd keresi a fejléc és a navigációs elemeket, és meghatározza, hogy melyik szakasz tartja a fő tartalmat. E folyamat során olyan elemeket is kivon, mint a rel = kanonikus, hreflang, linkek és horgonyok, valamint meta-robots címkék.

„Nincs preferencia a reagáló webhelyek között a dinamikus/adaptív webhelyekkel szemben. A Google nem próbálja ezt felismerni, és nincs kedvezményes súlyozása.” – Cherry Prommawin

A linkek továbbra is központi szerepet játszanak a webszerkezetben, mind a felfedezés, mind a rangsorolás szempontjából:

„A linkek továbbra is az internet fontos részét képezik, és új oldalak felfedezésére és a webhely struktúrájának meghatározására szolgálnak, és rangsorolásra használjuk őket.” – Cherry Prommawin

Az indexelés ellenőrzése a robotok szabályaival

Gary Illyes tisztázta, hogy a robots.txt és a robotok -meta címkék illeszkednek az áramláshoz:

- Robots.txt Ellenőrzi, hogy a rugók mit hozhatnak.

- Meta robot címkék Ellenőrizze, hogyan használják fel a letöltött adatok lefelé.

Számos kevésbé ismert irányelvet kiemelt:

- egyik sem: Egyenértékű

noindex,nofollowegyetlen szabályba kombinálva. Van -e előnye ennek? Noha funkcionálisan azonos, a kettő helyett egy irányelv használata egyszerűsítheti a címke kezelését. - Notranranslate: Ha beállított, a Chrome már nem kínálja az oldal lefordítását.

- NoImageIndex: A videoeszközökre is vonatkozik.

- Nem érhető el: után: Annak ellenére, hogy a mérnökök bevezetik őket, akik azóta továbbmentek, ez még mindig működik. Ez hasznos lehet az időérzékeny blogbejegyzések, például a korlátozott időtartamú ügyletek és promóciók leértékeléséhez, tehát nem maradnak fenn a Google AI szolgáltatásaiban, és megtévesztik a felhasználókat, vagy károsítják a márka észlelését.

Megérteni, mi van egy oldalon

Gary Illyes hangsúlyozta, hogy a Google Minőség -értékelési irányelveinek meghatározásával meghatározott fő tartalom, a mászás és az indexelés legkritikusabb eleme. Lehet, hogy szöveg, képek, videók vagy gazdag funkciók, mint például a számológépek.

Megmutatta, hogy egy téma a fő tartalomterületre való áttérése növelheti a rangsorolást.

Az egyik példában a „Hugo 7” -re való mozgó hivatkozások az oldalsávból a központi (Main) tartalomba vezettek a láthatóság mérhető növekedéséhez.

„Ha bizonyos dolgokra rangsorolni szeretne, tegye ezeket a szavakat és témákat fontos helyekre (az oldalra).” – Gary Illyes

Tokenizálás a kereséshez

Nem lehet a RAW HTML -t a skálán kereshető indexbe dobni. A Google „tokenek”, egyes szavak vagy kifejezések, és az indexében tárolják.

Az első HTML szegmentációs rendszer a Google 2001 -es Tokiói Műszaki Irodájába nyúlik vissza, és ugyanazok a tokenizációs módszerek táplálják az AI termékeit, mivel „miért találja újra a kereket”.

Ha a fő tartalom vékony vagy alacsony értékű, akkor a Google címkéje „lágy 404”, akkor egy középpontos annotáció jelöli, hogy megmutassa, hogy ez a hiány az oldal középpontjában áll, nem csak egy perifériás szakaszban.

A webes duplikáció kezelése

Cherry Prommawin elmagyarázta a deduplikációt három fókusz területen:

- Klaszterezés: Átirányítások, tartalom hasonlóság és rel = kanonikus csoportos duplikált oldalak felhasználása.

- Tartalom -ellenőrzések: Ellenőrző összegek, amelyek figyelmen kívül hagyják a kazánlemezet, és sok lágyhirdetési oldalt kapnak. Vegye figyelembe, hogy a lágy hibák egy teljes klasztert csökkenthetnek.

- Lokalizáció: Ha az oldalak csak lokálonként különböznek (például geo -rediurektusokon keresztül), Hreflang büntetés nélkül áthidalja őket.

Ellentéttette az állandó és az ideiglenes átirányításokat: mindkettő szerepet játszik a mászásban és a klaszterezésben, de csak az állandó átirányítások befolyásolják azt, amelyet az URL -t választanak a klaszter kanonikusnak.

A Google prioritást élvez az eltérítési kockázatot először, a második felhasználói élményt és a webhelytulajdonos jeleit (például a rel = kanonikus) harmadik a reprezentatív URL kiválasztásakor.

Földrajzolás

A geotargeting lehetővé teszi, hogy jelezze a Google -nak, hogy melyik ország vagy régió tartalma a legmegfelelőbb, és az egyszerű nyelvcélzáshoz hasonlóan működik.

Prommawin hangsúlyozta, hogy nem kell elrejtenie a duplikált tartalmat két ország -specifikus webhelyen; A Hrefang kezelni fogja ezeket a póttagokat az Ön számára.

Ha lokalizáció nélkül szolgálja fel a több példány tartalmat több regionális URL -en, akkor kockáztatja, hogy zavarja mind a robotokat, mind a felhasználókat.

A geotarget hatékonyságához győződjön meg arról, hogy minden verzió egyedi, lokalizált tartalommal rendelkezik, amely a saját közönségére vonatkozik.

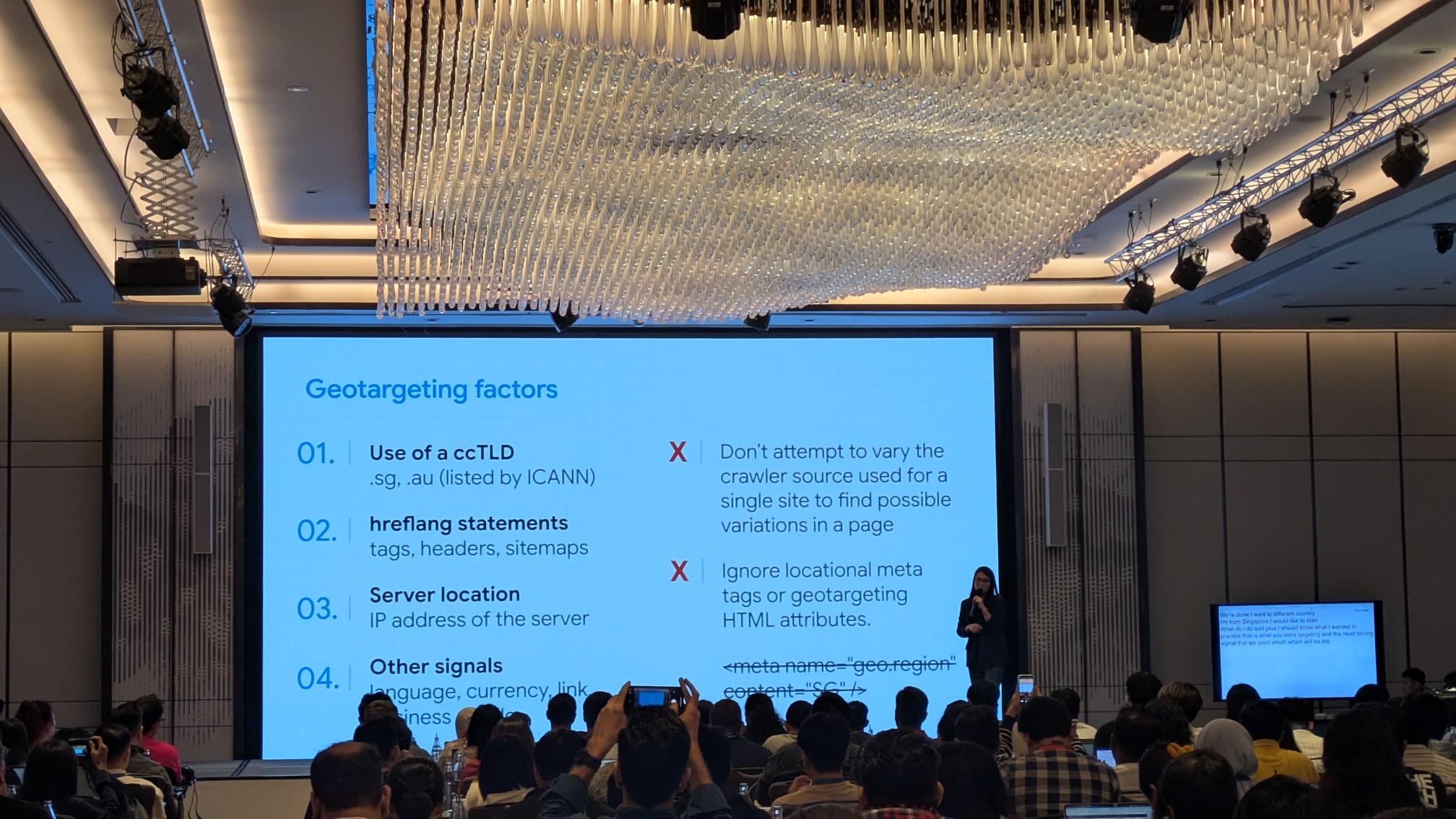

Az elsődleges geotargeting jelek a Google használata:

- Country -kód legfelső szintű tartomány (CCTLD): Olyan domainek, mint a .sg vagy a .au, jelzik a cél országot.

- Hrefang kommentárok: Használat Címkék, HTTP fejlécek vagy webhelytérképbejegyzések a nyelv és a regionális váltakozói deklaráláshoz.

- Szerver helye: A szerver IP -címe vagy tárhelyhelye földrajzi tippként működhet.

- További helyi jelekmint például Nyelv és valuta az oldalon, más regionális webhelyek linkjei, valamint a helyi üzleti profil jelei, mind megerősítik a célterületet.

Ha ezeket a jeleket valóban lokalizált tartalommal kombinálja, segít a Google -nak a webhely megfelelő verziójának kiszolgálásában a megfelelő felhasználók számára, és elkerüli a nem szándékos duplikált -tartós klaszterek hibáit.

Strukturált adatok és média

Gary Illyes bevezette a szolgáltatás extrakciós fázist, amely a deduplikáció után fut, és számítástechnikai szempontból drága. A HTML -vel kezdődik, majd külön, aszinkron médiaindexelést indít a képek és videók számára.

Ha a HTML az indexben van, de a média nem, akkor ez egyszerűen azt jelenti, hogy a médiavezeték továbbra is működik.

A pályán lévő munkamenetek tartalmazzák:

- Strukturált adatok William Prabowo -val.

- Képek használata Ian Huang -szal.

- A felhasználók bevonása videóval William Prabowo -val.

Kérdések és válaszok a sémán

A séma jelölése segíthet a Google-nak megérteni az entitások közötti kapcsolatokat és lehetővé teszi az LLM-vezérelt funkciókat.

De a túlzott vagy redundáns séma csak az oldal puffadását adja hozzá, és nincs további rangsorolási előnye. És a sémát nem használják a rangsorolási folyamat részeként.

Kiszámító jelek

A jelkivonás során, amely szintén az indexelés része, a Google kiszámítja a következőket:

- Közvetett jelek (linkek, más oldalak megemlítése).

- Közvetlen jelek (az oldalon lévő szavak és elhelyezések).

Illyes megerősítette, hogy a Google továbbra is a PageRankot használja belsőleg. Ez nem a pontos algoritmus az 1996 -os fehér könyvből, de ugyanazt a nevet viseli.

Kezelés spam

A Google rendszerei naponta mintegy 40 milliárd spam oldalt azonosítanak, amelyet LLM -alapú „Spambrain” táplálnak.

Ezenkívül Illyes hangsúlyozta, hogy az eeat nem indexelő vagy rangsorjel. Ez egy magyarázó elv, nem pedig a számított mutató.

Annak eldöntése, hogy mi indexel

Az index kiválasztása a minőségre terjed ki, amelyet a végfelhasználók megbízhatóságának és segédprogramjának kombinációjaként határoznak meg. Az oldalak az egyértelmű negatív jelek indexéből származnak:

noindexirányelvek.- Lejárt vagy időre korlátozott tartalom.

- Lágy 404 -es és átcsúsztatott másolatok.

- Tiszta spam vagy politikai jogsértések.

Ha egy oldal mászott, de nem indexelt, akkor a gyógyszer a tartalom minőségének javítása.

A belső összeköttetés segíthet, de csak amennyiben az oldal valóban hasznosabbá teszi. A Google célja a felhasználó által központú fejlesztések jutalmazása, nem pedig a jel manipuláció.

A Google nem érdekli, hogy a képei AI-generáltak-e

Az AI által generált képek gyakoriak lettek a marketing, az oktatás és a tervezési munkafolyamatokban. Ezeket a látványokat a mély tanulási modellek készítik, amelyek hatalmas képgyűjteményeken képztek.

A munkamenet során Huang körvonalazta, hogy a Google nem érdekli, hogy képeit az AI vagy az emberek generálják -e, mindaddig, amíg pontosan és hatékonyan továbbítják az információkat, vagy elmondják a kívánt történetet.

Mindaddig, amíg a képek érthetők, AI -eredetük nem releváns. Az elsődleges cél a hatékony kommunikáció a közönséggel.

Huang kiemelte egy példát egy AI -képre, amelyet a Google csapat használt a konferencia első napján, amelynek szoros ellenőrzésekor van néhány vizuális hibája, de „prop” feladata az idővonal ábrázolása volt, és nem volt a diák fő tartalma, tehát ezeknek a hibáknak nem számítanak.

Hasonló megközelítést alkalmazhatunk az AI által generált képek használatához. Ha a kép továbbítja az üzenetet, és nem az oldal fő tartalma, akkor a kisebb kérdések nem vezetnek büntetéshez, és általában nem fognak használni az AI által generált képeket.

A képeknek gyors emberi áttekintést kell végezniük a nyilvánvaló hibák azonosítására, amelyek megakadályozhatják a termelési hibákat.

A folyamatban lévő felügyelet továbbra is elengedhetetlen a látványban való bizalom fenntartásához és a márka integritásának védelme érdekében.

A Google Trends API bejelentette

Végül Daniel Waisberg és Hadas Jacobi bemutatta az új Google Trends API -t (Alpha). Az új API legfontosabb jellemzői a következőket tartalmazzák:

- Következetesen méretezett keresési érdeklődés -adatok, amelyek nem újrakalibrálják a lekérdezések megváltoztatásakor.

- Egy ötéves gördülőablak, amely 48 órával ezelőtt frissült, szezonális és történelmi összehasonlításokhoz.

- Rugalmas időbeli aggregáció (heti, havi, évente).

- Régió és alrégió bontása.

Ez megnyitja a programozási trendelemzés világát, megbízható, összehasonlítható mutatókkal az idő múlásával.

Ez becsomagolja a második napot. Holnap bemutatjuk a harmadik utolsó napot a Google Search Central Live -en, több hírekkel és betekintéssel.